Как во времена дипфейков научиться распознавать подлинное и мнимое

Реакция министра иностранных дел РФ Сергея Лаврова на показанный ему дипфейк с его лицом и голосом была иронической: "Вроде я". Но поддельные фото, видео- и аудиозаписи, созданные с помощью искусственного интеллекта, сегодня стали нешуточным бедствием. Их относят к одному из главных видов информационных угроз, а противостояние им становится актуальнейшей задачей. О том, не заменят ли дипфейки истину иллюзией, будет ли разрастаться это явление и что этому можно противопоставить, наш разговор с экспертами.

Насколько опасны дипфейки? Может, это пустые страхи, которые со временем проходят? Ведь подделки существовали всегда…

Надежда Серякова, основатель Национальной академии этикета и протокола InterProtocol, в прошлом заместитель шефа протокола президента России: Да, подделки существовали всегда: отфотошопленные изображения, поддельные документы, выдуманные истории, выдача себя за другое лицо… Как правило, эксперты-аналитики, фотографы, почерковеды и криминалисты легко их обнаруживали. Стоило только включить профессиональные навыки и опыт. Но с повсеместным переходом от аналоговых технологий к цифровым, еще совсем недавно, менее десяти лет назад, появился изощренный обман - дипфейк (от англ. deep learning + fake - глубинное обучение подделке). Он отличается не только тем, что является "более фальшивым", но и тем, что изменились метод, масштабы и психологическое воздействие на потребителя контента. Искусственный интеллект научился очень правдоподобно имитировать внешность, голос, движения, эмоции человека. И не надо быть большим специалистом для того, чтобы создавать очень реалистичные видео и фотографии с подменой личности или измененной реальностью.

Ольга Ускова, генеральный директор ГК "Когнитив Пилот": И дипфейки принципиально меняют существующую реальность. Основным параметром здесь является индекс доверия к экспертным данным и новостям. Если раньше этот показатель снижался по отношению к информации, которая выходила только в Сети или новостных каналах, то сейчас он упал даже в таких стандартных подтверждениях, как видео- и аудиоматериалы, которые генерируются с использованием соответствующих технологий и инструментов. Сегодня все труднее отличить сгенерированный контент от реального. А подрыв доверия к информации, когда никто никому не верит, - это разрыв общения, это полное изменение всей структуры деятельности общества.

Дипфейки в отличие от всех других видов фейков плохо распознаются?

Сергей Маклаков, начальник управления по противодействию распространению недостоверной информации АНО "Диалог Регионы": Можно однозначно утверждать, что дипфейки стали уже полностью нераспознаваемыми обычным взглядом человека. Новые генеративные модели ИИ, в том числе Sora 2, значительно способствовали этому. В сентябре-октябре 2025 года (как раз после выхода Sora 2 в публичный доступ) мы наблюдаем беспрецедентный рост количества сгенерированных нейросетями видео в целях дезинформации. Только за октябрь их выявлено 92 - больше, чем за весь прошлый год (84). А всего с начала 2025 года выявлено 432 таких дипфейка. Речь о поддельных видео, направленных на намеренное введение в заблуждение граждан и несущих социальную опасность.

Ольга Ускова: Поэтому сегодня очень важно создать механизмы контроля за этим процессом. Должны быть разработаны законы, запрещающие генерацию дипфейков, должны быть предусмотрены меры наказания за это. И еще необходимо, чтобы был учет специалистов, которые в состоянии создавать глубокие дипфейки. Но, к сожалению, законодательство в этой зоне пока еще находится в зачаточном состоянии.

Сергей Маклаков: Ответом на такую угрозу должен стать комбинированный подход, включающий совершенствование средств детектирования, основанных также на ИИ, таких как разработанная АНО "Диалог Регионы" система мониторинга дипфейков "Зефир", а также мероприятия по повышению навыков фактчекинга и развитию критического мышления пользователей.

При этом не стоит демонизировать технологии создания генеративного контента. Сами по себе они имеют высокий потенциал. А, например, в образовательных или художественных целях не обязательно всегда используются ради дезинформации.

Так ли тотально дипфейки (а их сегодня великое множество) закрывают проход к правде?

Валерий Федоров, генеральный директор АЦ ВЦИОМ: Нет, я, опираясь на данные наших опросов, считаю, что у нас все-таки формируется иммунитет к фейкам. После 10 лет активного присутствия темы фейков в общественном пространстве (о дипфейках говорят уже года три) российское общество в целом уже адаптировалось к этому явлению. Наши опросы показывают, что о фейках все знают. И практически все уже попадались (некоторые не раз). И при этом большинство уже понимает, что нельзя верить всему, что сообщают, что информацию надо проверять.

А есть ли кроме собственно технических программ надежные способы верификации информации?

Валерий Федоров: Ну, во-первых, ее должны верифицировать те, кто информацию передает, в первую очередь журналисты. Если в газету придет пресс-релиз, например, из ведомства, его же никто не кинется тут же печатать. Вступят в силу все процедуры проверки… Процедуры фактчекинга точно есть во всех традиционных СМИ. У новых СМИ - блогеров, авторов соцсетей - их практически нет - и в этом сложность. С этим надо работать.

А если говорить о получателе информации, о тех, кому эти фейки адресованы…

Валерий Федоров: И им известны механизмы проверки полученной информации. Например, найти ей подтверждение в независимых источниках. И прежде чем рассылать эту информацию своим знакомым, позвонить или написать эксперту в этой теме и уточнить у него, а правда это или нет?

До появления ИИ люди считали "Видеть - значит верить". Сегодня необходимо принять за правило: "Перепроверить, чтобы поверить"

Наши опросы показали, что нам уже не так страшны всевозможные фейки, потому что мы умеем с ними обращаться. Это не значит, что фейки больше не работают. Конечно, работают. Но тут соревнование брони и снаряда. Придумали суперброню, снаряд ее не пробивает, идут придумывать новый снаряд, потом опять суперброню… С фейками и защитой от них также. Как только люди поняли, как разбираться с фейками, фейкометы их модифицируют и т.д.

Но, повторюсь, наших людей уже не надо считать такими уж беззащитными агнцами, молча идущими на заклание. Нет, это не так. Определенный иммунитет уже сформировался. Он не абсолютный, но, я бы сказал, серьезный.

Сергей Вотяков, председатель Координационного совета Ассоциаций МСП в сфере искусственного интеллекта: Я тоже считаю, что проблема не должна превращаться в фобию дипфейков. К тому же немного "детскую". Если сравнить ИИ с электрификацией, то мы в стадии, когда зажглись пять тысяч лампочек на Земле, но еще не придуманы не то что айфоны, а даже станки, которые работают от электричества.

Но оставлять даже искушенного потребителя информации один на один с мошенниками-фейкометателями не стоит?

Сергей Вотяков: Конечно. Проблема дипфейков должна решаться регуляторно. То есть должно быть жесткое наказание за совершение противоправных действий при помощи ИИ. И это наказание должно быть неотвратимым. Для этого мы будем использовать ИИ для мониторинга.

Машины учатся у людей, но они берут от нас не только хорошее, но и плохое. Разметки данных надо фильтровать и давать машине, чтобы она обучалась на правильных кейсах. Вот почему надо регуляторно заставлять разработчиков, чтобы они размечали данные или синтезировали их. Кстати, это сделали в Китае ряд компаний. Там четко: если появились деструктивные данные - это вина разработчика.

И что же нас все-таки ждет? Каковы прогнозы?

Руслан Юсуфов, футуролог, основатель аналитического агентства MINDSMITH: Английский футуролог Артур Кларк считал, что продвинутая технология неотличима от магии. И я вижу, что у нас значительная часть общества живет в магическом мышлении и обращается к звездам или к специалистам гадания на кофейной гуще для прогнозирования чего-то. И тут высок риск ошибок и злоупотреблений.

И какие риски самые серьезные?

Руслан Юсуфов: Один из рисков - человек превращается в шахту по добыче данных. У нас много биометрической информации - сердце ценно, зрачок расширяется так репрезентативно, что его можно анализировать и превращать в облачный след для создания как большего комфорта, так и для манипуляций. И опасен не только взлом гаджетов, но и взлом тела, бионических протезов, взлом головы, и по этой части кибермошенники развиваются быстрее нейроимплантов.

Ключевой проблемой может стать эрозия доверия в обществе. Мы уже не доверяем друг другу, перестанем доверять институтам, потому что они ломаются… И начнем жить в гиперкоконе, информационном пузыре, который создается уникальной лентой под меня, уникальным потоком. От стриммингового потока сериалов Нетфликса для меня до уникальной их интерпретации тоже для меня. Эта эрозия доверия может привести к тому, что мы, живя в разных мирах и физически сидя за одним столом, перестанем иметь общее дело. Так сегодня происходит с родителями и детьми, которые физически собрались вечером поужинать, но каждый сидит в своей ленте, в своем инфополе, в своем виртуальном мире. Вот наши будущие расколы.

Еще один раскол - расширение возможностей человека в погоне за новыми профессиями. И вот мы уже в обойме магии "цифры" и уверены, что "мое тело - мой храм".

Как этому противостоять?

Надежда Серякова: Уверена, что очень скоро мы подойдем к принятию законов, регламентирующих киберпространство. Как, например, это сделали в Китае. Они приняли один из самых прямых законов о дипфейках и обязали производителей контента помечать дипфейки, подтверждать личность пользователей и наказывать авторов, вводящих в заблуждение читателей и зрителей.

Руслан Юсуфов: Я думаю, что нам нужны регуляторные документы для разработчиков. А вузы надо подключить к подготовке специалистов по распознаванию дипфейков.

У нас уже есть специалисты по противостоянию дипфейкам?

Сергей Вотяков: У нашего совета, созданного на полях Петербургского международного экономического форума (ПМЭФ), есть программа "ТОП ДС" в 22 вузах по подготовке специалистов, умеющих противостоять дипфейкам.

Но у нас нет временного разбега, специалистов. И правил регуляции тоже пока нет.

Руслан Юсуфов: Надо дорожить и тем, что у нас есть, и правилами, которые мы сами для себя формулируем и стараемся соблюдать. Но нет никакого наказания, если мы их не соблюдаем. Это мягкое регулирование. Но нужен другой параллельный шаг - договориться об этике среды, в которой мы будем жить. Договоримся - не будем говорить о страхах в режиме постоянного алармизма, а будем влиять на ситуацию. Не только со стороны государства, но и со стороны пользователей. И именно от пользователей родится тот небольшой радиус доверия, который характерен для обществ, переживших ту или иную фобию. Но страхи надо снимать в том числе и через доверие, рождаемое сводом этики "цифры". Постепенно, с расширением радиуса влияния на цифровую среду, будет расти и наша способность отличать правду от лжи.

Но от дипфейков, кажется, может быть и польза. Речь, например, идет об эволюции воспоминаний. Раньше мы могли полистать фотоальбом, затем смотрели подборку видео, а теперь говорим с виртуальными моделями…

Надежда Серякова: Да, дипфейк может нести и позитивный смысл (и это хорошая новость). Он помогает воссоздавать то, что не удалось запечатлеть в свое время. Так, например, недавно в Москве прошло шоу "Высоцкий. Высота" с использованием цифрового аватара Владимира Высоцкого, созданного с помощью дипфейка. Зрители увидели "живого" Высоцкого, который исполнил 18 песен под аккомпанемент оркестра и в присутствии других цифровых аватаров. Это было первое подобное выступление в истории российского шоу-бизнеса.

Еще одна серьезная проблема: наши суды пока разрешают предоставлять видео в качестве доказательства. А если такие видео начнут генерироваться с помощью ИИ?

Надежда Серякова: До появления искусственного интеллекта люди принимали увиденное за истину: "Видеть - значит верить". Сегодня необходимо принять за правило: "Перепроверить, чтобы поверить". Особенно если речь идет о провокационном или шокирующем контенте. Нет реальных механизмов определения дипфейков. И еще грустнее - у ИИ нет нравственных принципов и морали. Это порождает как минимум две опасности: во-первых, дипфейк заставляет людей верить во что-то ложное, а во-вторых, появляется "дивиденд лжеца", когда любой виновный может объявить видеодоказательства подделкой.

Нашим слушателям, работающим с фото- и видеоинформацией для публичных выступлений, мы предъявляем жесткое требование - собрать информацию из пяти источников, прежде чем опубликовывать материал для дальнейшего продвижения.

И если бы не наша щепетильность, то на информационных просторах давно бы ютились, например, фотографии корейских военных чинов с орденами и медалями на форменных брюках или заблюренные якобы государственными телевизионными каналами арабских стран выступающие с трибуны женщины-лидеры. Перепроверили, оказалось, дипфейки.

А пока выбираем надежный источник информации, такой, где все перепроверяется, прежде чем публиковать.

Прямая речь

У нас уже 5000 историй с разоблачением дипфейков

Мария Захарова, директор департамента информации и печати, официальный представитель МИД России:

- Скоро, к сожалению, весь мир будет опутан этими самыми дипфейками. Скорость сумасшедшая, нет никаких ограничений, в том числе юридических, пока нормы не разработаны ни в отдельных государствах (я сейчас про все государства говорю), ни в международном правовом поле...

Пока мы буквально хватаем за руку нечистоплотных, зачастую проплаченных, так называемых журналистов, блогеров, медийщиков, которые это все исполняют, вот эти все информационные казябры. Делаем детальные материалы-разборы с разоблачениями. Они включают методологию, факты, аналитику.

За это время опубликовано более 350 больших разборов-опровержений вот таких мощных историй. А если говорить об опровержениях как таковых, то более 5 тысяч.

Особое мнение

Надо обучать людей отличать подлинное от мнимого

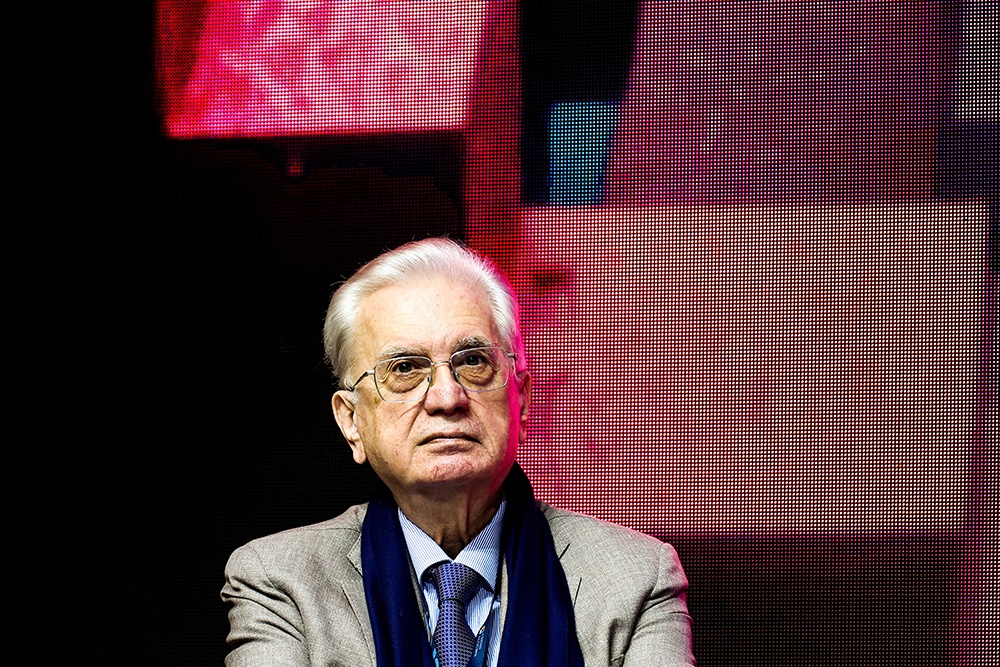

Михаил Пиотровский, генеральный директор Эрмитажа, академик РАН:

- В Эрмитаж приходят дипфейки с моим лицом и голосом и с лицами и голосами моих заместителей. Ну что тут можно сказать? Теперь нам приходится проходить еще и через такое испытание, как дипфейки…

Мне, кстати, куда больше слова "дипфейк" нравится слово "аватар", реже используемое, но означающее то же самое.

Поскольку у нас и раньше было полно проблем со всякими атаками мошенников с требованиями предоставить пароль и личные данные, то мы уже научились не обращать внимания на такие запросы. Мы держим фронт и сейчас и пока со всем справляемся - не верим высокотехнологичным подделкам, не запутываемся в этом.

Будет сложнее - будем дальше учиться. И обучать других людей отличать подлинное от мнимого. Так же, как когда-то обучались пользоваться интернетом… Фраза о том, что "войну выигрывают учителя", по-прежнему актуальна.

Надо еще и понимать, что свойствами фейка обладают некоторые наши фундаментальные "знания". Александр Невский в глазах большинства не защитник Невских рубежей, а созданный Эйзенштейном образ эпического героя мифического ледового сражения, столь же достоверный, как и его же штурм Зимнего. Еще и с искажающей смысл игрой фразы из Евангелия от Матфея про вынувшего меч… Складывается ощущение, что мы часто живем историческими фейками. Хотя еще остаются люди, которые знают и понимают, что реальность другая.

Наша великая живопись тоже - в пределе - иллюзии, фейки и дипфейки. Но мы, столетиями любуясь картинами, уже умеем понимать разницу между красавицей на портрете и красавицей в жизни.

У нас скоро будет выставка портрета и повод порассуждать над вопросом, что такое портрет. Это не кража лица? Не кража души? Или выражение души?

Поговорим об иконоборческой традиции, в которой нельзя изображать человека. Ведь целые цивилизации - иудейская, исламская - не принимали формы искусства, изображающие человека. В таких культурах боялись и портретов, и фотографий, и кино, и телевидения.

Так что есть практическая сторона поведения - не брать телефон, если не знаешь, кто звонит, не открывать непонятные видео… Но есть и повод поразмышлять над тем, сколь много в нашей жизни иллюзорного. И мы с этим иллюзорным справляемся. Уже ведь не путаем живописное изображение с человеком. Хотя иконоборцы хотели уничтожить иконы, потому что им казалось, что можно нарисовать так, как будто это настоящее.

Так что подобное явление существовало всегда, и нам можно к этому присмотреться, чтобы приспособиться к новой реальности.

Искусствоведы знают: уверенность, что мы легко можем отличить подлинное от неподлинного, - тоже часть наших иллюзий. "Подлинные ученики", "подлинная мастерская", а потом выясняется, что этакой подлинности в абсолютном смысле слова почти никогда нет. И подлинное, и неподлинное существуют вместе.

Нам надо учиться не просто различать подлинное или неподлинное, а понимать суть. Различать смыслы. Это сложно, но сложность здесь нам помощник.

Через понимание, что все сложно, через умение различать смыслы мы как раз и можем разобраться, что правильно, а что неправильно, что достоверно, а что нет, что наше, а что не наше.