Нейросеть Stable Diffusion: что это такое, как ей пользоваться, гайд для установки на ПК

В последние годы стремительно развивается генеративный искусственный интеллект — появляется все больше нейросетевых решений, позволяющих создавать картинки и текст. И юзеры этим начинают активно пользоваться: так, почти треть опрошенных художников хоть раз использовали нейросети в творческом процессе. «Лента.ру» рассказывает, как установить на свой персональный компьютер (ПК) и как пользоваться нейросетью Stable Diffusion.

Stable Diffusion: что это такое

Stable Diffusion — это генеративный искусственный интеллект, натренированный для создания изображений. Был создан компанией Stability AI.

Вот основные способы его применения:

генерация изображения по текстовому запросу; дополнение или изменение изображения на основе существующего; создание динамических изображений или проектов.

Принцип работы

О принципе работы Stable Diffusion в беседе с «Лентой.ру» рассказал эксперт по нейросетям, автор курса для школьников «Нейросети для учебы и жизни» в «ИнтернетУрок» Александр Жадан: «У Stable Diffuison диффузионный принцип генерации. Это значит, что в нейросети собрана большая база исходных изображений (пары картинка-текст), к которым добавляется шум, чтобы делать новые изображения за счет добавления деталей. Если не добавлять шум, то на выходе нейросеть просто выдавала бы имеющиеся файлы из своего набора».

Руководитель группы продуктов факультетов геймдизайна и разработки игр и искусственного интеллекта Университета «Синергия» Сергей Толокольников поясняет с помощью понятной метафоры: «Представьте, что нейросеть берет описание, например, "дом в лесу зимой", и поэтапно, как если бы размытые очертания становились все четче, создает изображение. В основе процесса лежит работа с шумом, который постепенно превращается в детализированную картину».

Как развивались генеративные нейросети Первые генеративные нейросети были коммерческими: их нельзя было загрузить на компьютер, дополнить и дообучить под свои задачи. Со временем появились open-source модели, доступные для скачивания. По словам директора по инновациям Wink и преподавателя Британской высшей школы дизайна Артема Орлова, самой популярной стала именно Stable Diffusion: «Любой мог скачать XL-версию, закинуть туда сто изображений Москвы, например, и на выходе получить модель, которая знает все про город». Развитие пошло дальше: в 2023 году добавился дополнительный AI-инструмент (AI ― от англ. artificial intelligence, «искусственный интеллект»), ControlNet, с помощью которого пользователи могли генерировать изображения не только на основе текстового промта, но и с помощью других изображений и набросков.

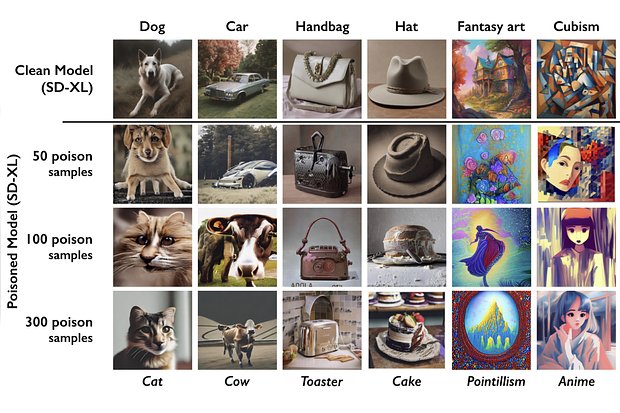

Проблемы с авторским правом

О проблемах с авторским правом «Ленте.ру» рассказал эксперт по ИИ, основатель и директор проекта BotB2b Виктор Попов. По его словам, команда Stability AI использовала для обучения нейросети картины известных художников, изображения с сайтов-агрегаторов, где авторы продают свои работы или выкладывают в бесплатный доступ.

«Именно это привело к большому Польши, создателя популярных фэнтези-артов Грега Рутковски».

Stable Diffusion обучалась на работах Грега Рутковски, потом пользователи нейросети создали много изображений в стиле художника. А теперь фанатские работы стали популярнее оригиналов

В России нейросетевое творчество пока находится в серой правовой зоне, и единого решения по авторскому праву в отношении сгенерированных изображений пока не было найдено.

Целевая аудитория

По мнению эксперта по нейросетям Александра Жадана, Stable Diffusion — это более профессиональный инструмент, в отличие от программ Midjourney, Dalle или Kandinsky. «Если приблизительно сравнивать, то Midjourney, Dalle, Kandinsky — это фотография в хороший солнечный день на последний iPhone, а Stable Diffusion — это снимок на профессиональный фотоаппарат с большим объективом, со штативом и так далее. Как и с фото, у новичка может получиться слишком темный кадр или с точки зрения композиции некрасивый. Поэтому нужен особый подход и настройка».

Где и как использовать Stable Diffusion

Использовать Stable Diffusion можно двумя способами, рассказала в беседе с «Лентой.ру» технологический предприниматель, управляющий партнер платформы LMS/LXP Distant Global Наталья Абабий:

онлайн; скачав одну из десктопных версий на свой компьютер.

По словам Абабий, возможности онлайн-версии ограничены, в нее нельзя загрузить референсы изображений, а размер картинок у нее стандартный — 512x512 пикселей.

Использование нейросети онлайн

Чтобы использовать нейросеть онлайн, нужно воспользоваться сервисами.

DreamStudio

Это онлайн-сервис авторства команды, разработавшей Stable Diffusion. Сервис не бесплатный, в нем, как и во многих других нейросетевых решениях, используется система кредитов — особой валюты, которой можно платить за генерацию.

Чтобы дать пользователям, ранее не генерировавшим картинки, шанс опробовать сервис, администрация начисляет новым юзерам по 100 кредитов. Этого хватает, чтобы сгенерировать 500 изображений на стандартных настройках. В зависимости от сложности дополнительных настроек цена за промпт может меняться. Когда кредиты закончатся, можно приобрести новые — тысячу штук за 10 долларов, но для покупки понадобится иностранная банковская карта.

Hugging Face

Крупнейшая платформа для работы с моделями. На ней выложены версии Stable Diffusion, с которыми можно бесплатно поработать онлайн, но иногда генерация может занимать больше 20 секунд, и функционал немного обрезан. Также на сервисе есть генератор детализированных промптов для тех, кто не уверен в своих силах промпт-инженера.

RenderNet

Приложение (веб и мобильное) с удобным интерфейсом. В разделе Studio доступны более 30 популярных моделей. По умолчанию создаются изображения в высоком разрешении без дополнительной платы за улучшение качества. В разделе «Аватар» можно загружать фотографии и превращать их в художественные работы, используя один из 17 стилей.

Night Cafe

Сайт для генерации изображений и сообщество для AI-энтузиастов. Нейросетевые художники могут делиться результатами своего творчества и следить за чужими успехами. Предлагает разнообразные стили и возможности настройки промптов. Бесплатно доступны только старые модели, для новых требуется покупка кредитов.

Sinkin AI

Платформа для генерации изображений на базе моделей Stable Diffusion с оплатой авторам за использование. Сервис платный, доступны кредиты за регистрацию, но иногда генерация занимает много времени.

Mage Space

Сайт с бесплатной генерацией изображений на базе моделей Stable Diffusion. Платный доступ нужен для файнтьюнинга, то есть для тонкой настройки моделей и расширенных параметров. Бесплатный план включает неограниченные генерации и изменение качества.

Playground AI

Бесплатный и безлимитный сервис на стыке социальной сети и сервиса для генерации изображений.

Использование нейросети на ПК

В десктопной версии больше дополнительных настроек — можно менять размер изображений и добавлять референсы, но для работы с ней потребуется видеокарта с объемом оперативной памяти 4 или 8 Гб (для обладателей Mac — процессор M1 или M2).

Чтобы установить Stable Diffusion на персональный компьютер, нужно предпринять следующие шаги.

Установить на компьютер Python версии 3.10.6. по инструкции с официального сайта или воспользоваться другими методами (контейнер Docker, pyvenv, conda). Установить систему контроля версий Git — с помощью нее можно клонировать (копировать) папки с программами. Создать аккаунты на GitHub.com и Hugging Face. Открыть на своем компьютере программу Git Bash. Запустить команду cd и указать реальный пусть к папке на вашем компьютере по образцу path/to/your/folder, чтобы перейти в папку, куда вы хотите скачать программу. Клонировать репозиторий с интерфейсом с помощью команды git clone. Если все пройдет успешно, в выбранной папке появится папка stable-diffusion-webui. Зайти на Hugging Face и скачать нужную модель. Зайти в папку stable-diffusion-webui\models\Stable-diffusion, найти файл с названием Put Stable Diffusion Checkpoints here и переместить его туда. Открыть командную строку. Перейти в папку с моделью с помощью команды cd и пути по образцу path/to/stable-diffusion-webui (изменить для пути в вашем компьютере). Запустить команду webui-user.bat. В командной строке появится адрес http://127.0.0.1:7860/. Его нужно ввести в адресную строку браузера, и можно приступить к генерации.

Как генерировать изображения с помощью Stable Diffusion

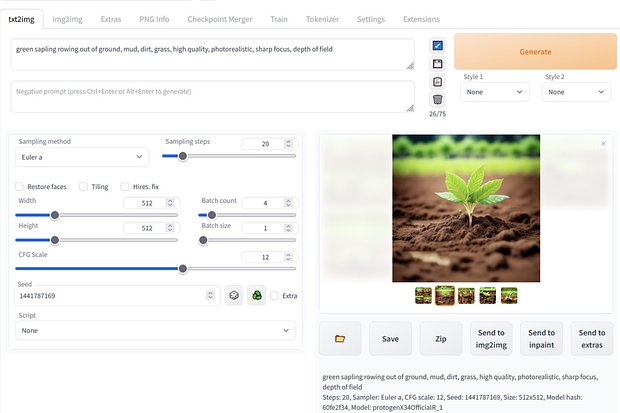

Нейросеть может генерировать изображения на основе промпта или готового изображения.

Как составить промпт

Превращение текста в изображение — базовая функция, которую нейросеть может выполнять вне зависимости от модели. Абабий советует начать промпт с указания ключевых объектов, поскольку нейросеть придает большее значение словам в начале текстового запроса.

Далее следует перейти к описанию действий и характеристик объектов. «Не забудьте про место действия и стилистику изображения — можно взять за основу стили популярных живописцев, фотографов и игровых концепт-артов, — посоветовала собеседница «Ленты.ру». — Подсмотреть готовые промпты можно в сообществе PromptoMania — здесь собраны изображения и их подробные описания для работы со Stable Diffusion».

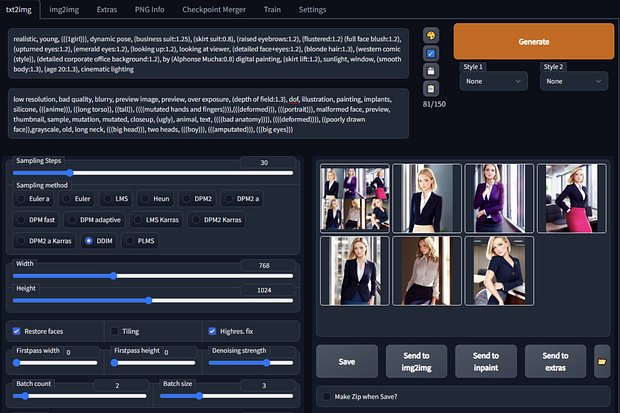

Для более эффективной работы с Stable Diffusion нужно уметь не только составлять хороший промпт, но и ознакомиться со списком параметров. От них зависит, как будет выглядеть финальное изображение.

Отрицательный промпт

Negative Prompt — это указание на то, чего не должно быть на изображении.

Общие:

lowres (низкое разрешение); error (ошибки); cropped (обрезанное изображение); worst quality (низкое качество); jpeg artifacts (артефакты); watermark (водяной знак); signature (подпись).

Для портретов:

deformed (деформированный); extra limbs (дополнительные конечности); bad proportions (плохие пропорции); poorly drawn face (плохо нарисованное лицо); long neck (длинная шея).

Для фотореалистичных изображений:

illustration (иллюстрация); painting (картина); drawing (рисунок); sketch (эскиз).

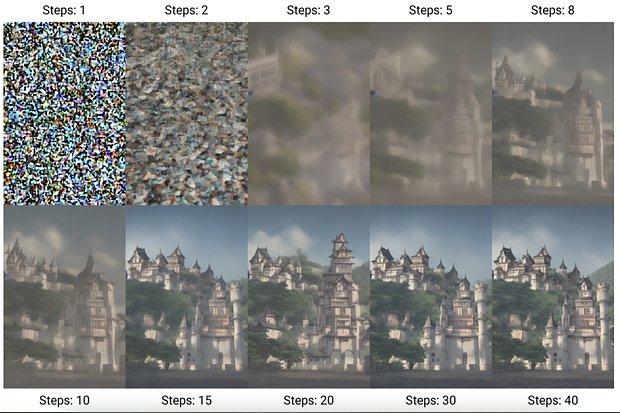

Количество шагов

Steps — количество шагов, за которое ИИ создает изображение, начиная с шума.

10-15 steps (шагов) — для быстрого тестирования промпта; 25 steps (шагов) — для стандартного качества изображения; 40 steps (шагов) — для текстурных деталей (шерсть у животных, черты лица).

Уменьшение шума

Samplers (сэмплеры) — алгоритмы, управляющие процессом уменьшения шума. Самые популярные:

Euler A — мягкие цвета, менее четкие границы, «сказочный» эффект. DDIM — быстрые и точные результаты. DPM Solver++ — улучшенные результаты при меньшем количестве шагов.

Свобода действий

CFG Scale (шкала CFG, также Prompt Strength) определяет баланс между свободой действия ИИ и точностью исполнения промпта.

2-6 — с большой свободой для творчества, но может сильно исказить результат. 7-10 — оптимальный баланс между креативностью и точностью. 10-15 — для детализированного и четкого промпта. 16 и выше — редко используется, возможны искажения и плохое качество.

Начальный шум

Seed (сид) — число, определяющее начальный шум, от которого зависит финальное изображение. Одинаковый сид + одинаковый промпт = одинаковое изображение. Это значит, что при использовании разных (или рандомизированных) значений сида программа несколько раз выдаст разные изображения даже при одинаковых промптах, а использование одного и того же сида при одинаковых промптах выдаст одинаковые изображения в разные генерации. Это полезно для контроля характеристик, тестирования изменений и смены стиля.

Изображение из изображения

Img2img — создание картинки на основе загруженного изображения, к которому добавляется шум в зависимости от параметра Strength (Сила).

0.5-0.75 — для создания вариаций изображений. 0.25 — для смены стиля при сохранении исходных черт.

Разрешение

Resolution (разрешение) — размер картинки. Разные модели тренировались на картинках разного размера, поэтому лучше выбирать разрешение в зависимости от модели, которую вы будете использовать.

Модель

Stable Diffusion — это целое семейство моделей (Model). Существует не только несколько официальных релизов, но и множество моделей, обученных пользователями благодаря тому, что у Stable Diffusion открытый код.

Официальные релизы включают:

Stable Diffusion 1.x — первая серия моделей с разрешением 512x512 пикселей и 860 миллионами параметров. Хороша для общего использования, но ограничена в детализации и плохо понимает сложные промпты. Stable Diffusion 2.x — модели с разрешением 768x768 пикселей. Лучше обрабатывают сложные запросы, но промпты из первой версии работают хуже. Удобны для пейзажей и архитектуры, но есть цензура на некоторых знаменитостей и стили. Stable Diffusion XL 1.0 — выпущена в 2023 году, поддерживает разрешение 1024x1024 пикселей. Сильно улучшены цвета и композиция, лучше понимает сложные запросы. Требует много ресурсов и может быть сложной для запуска на обычном компьютере. SDXL Turbo — упрощенная версия SDXL 1.0 для быстрой генерации изображений 512x512 пикселей. Быстрая и эффективная, но ограничена лицензией только для личного использования. Stable Cascade — использует новую архитектуру для более эффективного обучения. Поддерживает разрешение 1024x1024 пикселей и лучше понимает запросы, но требует много видеопамяти и пока мало используется в сообществе.

Разработчики моделей советуют начинающим художникам экспериментировать с разными моделями в зависимости от стиля будущих картинок и целей генерации. В таблице ниже представлены популярные стабильные модели.

Stable Diffusion: главное о нейросети

Stable Diffusion — модель, обученная на парах «картинка — текст». Она начинает генерацию с шума, постепенно уточняя изображение. Можно скачать модель и запустить ее у себя на ПК, но «железо» должно быть мощным. И потребуются минимальные навыки работы с командной строкой (программой для прямого обращения к компьютеру) и гитом (программой для контроля версий программ). При генерации важно использовать хороший и подробный промпт, а также указать параметры. Разные релизы официальных моделей и обученные энтузиастами альтернативные версии хороши для разных задач. Фотореализм и аниме-арты лучше генерировать разными моделями. Модель бесплатная, но онлайн-оболочки могут быть платными. Каждая из оболочек обладает разным набором функций.