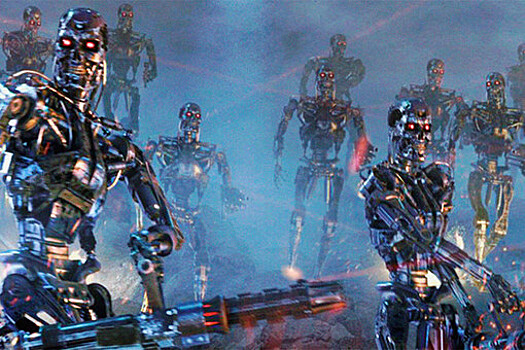

Заместитель главы научных исследований OpenAI Илья Суцкевер покинул компанию, что привело к распаду команды по управлению рисками, связанными с искусственным интеллектом. Согласно сообщению CNBC, эта группа была создана для защиты цивилизации людей от угроз, возникающих в связи с распространением ИИ. Однако она не просуществовала и года. Сообщается, что Илья Суцкевер, который ранее возглавлял эту команду вместе с Яном Лейке, был обеспокоен подобными рисками давно. Несмотря на первоначальные планы выделять до 20% вычислительных ресурсов компании для минимизации рисков, связанных с ИИ, в ближайшие четыре года, после ухода руководителей команды ее оставшиеся члены были переведены на другие должности внутри компании. Ян Лейке также недавно объявил о своем уходе из OpenAI, заявив, что "культура безопасности и процессы уступили место сияющим продуктам". Генеральный директор OpenAI Сэм Альтман выразил сожаление по поводу его отставки. Лейке отметил, что он уже давно не разделяет взгляды руководства на приоритеты развития компании и эти противоречия достигли критической точки. Как сообщает Лейке, профильная команда внутри OpenAI, которая занималась вопросами безопасности и влияния технологий на общество, буквально "ходила по воде под парусом против ветра" в последние несколько месяцев. Он по-прежнему убежден, что OpenAI должна делать безопасность приоритетным направлением в разработке генеративного ИИ, поскольку "создание машин, превосходящих людей, – это очень опасная затея".