Big Data (в переводе с английского «Большие данные») — это термин, который используется для описания колоссальных объемов данных, которые невозможно эффективно обработать с использованием традиционных методов. То есть с ними не справится ни обычный человек, ни простой пользовательский компьютер. Для обработки больших данных применяют специальные технологии и программное обеспечение. При этом огромные объемы информации можно использовать для решения задач, требующих высокой точности прогнозов, поиска обоснований для тех или иных решений, персонализации сервисов и так далее. «Лента.ру» рассказывает, что такое Big Data и в каких областях она применяется.

Что такое Big Data?

Как рассказал «Ленте.ру» эксперт по искусственному интеллекту и нейросетям Андрей Наташкин, впервые термин Big Data появился в 2008 году в статье профессора Школы информации Беркли Клиффорда Линча. Этим термином он обозначил взрывной рост мировых объемов информации. Безусловно, говорит эксперт, эти объемы существовали и ранее, но именно Линч четко обозначил проблематику и ввел понятийный аппарат.

Чаще всего к категории Big Data относится поток данных свыше 100 Гб в день

«Давайте представим огромный гипермаркет, где есть продуктовый отдел, одежда, бытовая химия, детские товары. В таком гипермаркете все четко структурировано. И именно это позволяет вам легко найти нужный товар. А теперь представьте, что вы приходите в гипермаркет, а там все вперемешку. Сапоги стоят вместе с молоком, а подгузники рядом с садовым инвентарем. Никакой логики и системности. Без Big Data наш мир был таким же», — говорит Андрей Наташкин.

Для характеристики Big Data традиционно используются три основных аспекта, которые называются «тройкой больших данных» или «3V» (в английском языке все три термина начинаются с латинской буквы V):

«Объем» (Volume)

Большие данные означают огромные объемы информации. Это включает в себя терабайты, петабайты и даже эксабайты данных.

«Разнообразие» (Variety)

Big Data может иметь различные форматы, включая текст, изображения, видео, аудио и структурированные данные, такие как таблицы и базы данных. Разнообразие информации также включает в себя данные в реальном времени и данные с географическими координатами.

«Скорость» (Velocity)

Скорость обработки и анализа данных в реальном времени является ключевым аспектом Big Data. Информация может поступать со скоростью нескольких тысяч транзакций в секунду.

Кроме того, со временем к тройке больших данных стали добавлять еще два признака:

«Истинность» (Veracity)

Это качество данных, включая точность, надежность и актуальность.

«Ценность» (Value)

Это способность извлекать ценную информацию и знания из больших данных и использовать их в бизнесе или исследованиях.

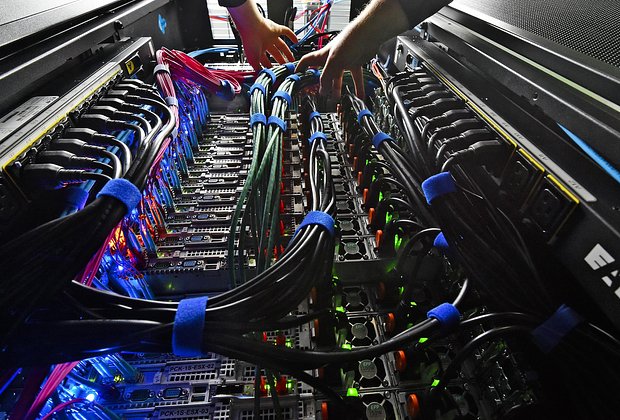

Обработка больших данных включает в себя использование специализированных технологий и инструментов, таких как:

системы распределенных хранилищ данных (например, Hadoop, Apache Spark); технологии обработки потоков данных (например, Apache Kafka); методы машинного обучения; алгоритмы анализа, чтобы извлекать ценную информацию и понимание из огромных объемов данных.

Где применяется Big Data?

Бизнес и маркетинг

Компании используют анализ больших данных для прогнозирования трендов, анализа рынка, оптимизации цен, улучшения клиентского опыта и принятия решений на основе данных.

«Поэтому требуется эти данные структурировать и сделать удобными для обработки, например, для того, чтобы обеспечить персонализированный и клиентоориентированный подход при производстве товаров и услуг», — рассказывает «Ленте.ру» заведующий кафедрой безопасности РАНХиГС Санкт-Петербург, доктор экономических наук Александр Дмитриев.

На огромных объемах данных маркетологи, бренд-менеджеры и продуктовые специалисты могут прогнозировать поведение потребителей и разрабатывать персонализированные предложения, увеличивая таким образом лояльность клиентов и конверсию, продолжает директор по маркетингу платформы автоматизации маркетинга Maestra Филипп Вольнов.

В качестве успешного примера использования Big Data он приводит известный российский обувной бренд. «С помощью больших данных в компании смогли понять, какие клиенты, ушедшие с сайта, вероятнее всего совершат покупку, и сфокусировали ретаргетинговые кампании конкретно на них, значительно увеличив конверсию и сэкономив бюджеты», — говорит эксперт.

Это значит, что человек, который хотел купить обувь, но не сделал этого (например, отправил понравившуюся пару в корзину, но решил пока не оплачивать), будет получать рекламу бренда снова и снова. В конце концов наиболее заинтересованные люди оплатят покупку. А вот юзеры, которые случайно попали на сайт, такую рекламу получать не будут — это значительно сэкономит бюджет магазину.

Здравоохранение

В медицинской сфере большие данные помогают улучшить диагностику, предсказывать распространение болезней, оптимизировать процессы лечения пациентов и проводить исследования в области медицины.

Финансы

Финансовые учреждения используют Big Data для анализа клиентских данных, предсказания рыночных трендов и оптимизации инвестиционных стратегий.

Транспорт и логистика

Компании в области транспорта и логистики используют большие данные для оптимизации маршрутов, управления инфраструктурой и улучшения эффективности транспортных средств.

Наука

В научных исследованиях Big Data используются для обработки и анализа огромных объемов данных, например, в астрофизике, генетике, климатологии и других областях. В частности, в НАСА Big Data применяют, чтобы просчитать детали будущих миссий.

Социальные медиа и интернет

Компании, работающие в области социальных медиа, используют большие данные для анализа поведения пользователей, персонализации контента и улучшения рекламных кампаний.

Онлайн-платформы, у которых миллионы подписчиков, анализируют предпочтения своих клиентов, в частности, какие фильмы и сериалы они больше всего смотрят, а какие игнорируют, бросают смотреть или перематывают. Это обеспечивает понимание психологии целевой аудитории и позволяет грамотно рекомендовать им новый контент Александр Дмитриев доктор экономических наук

Государственное управление

Власти стран используют технологии Big Data для анализа данных о гражданах, улучшения государственных услуг, предсказания социальных и экономических трендов.

Образование

В образовательных учреждениях данные используются для адаптации программ, улучшения обучения, оценки успеваемости студентов и оптимизации управления учебными заведениями. Кроме того, как говорит Дмитриев, Big Data помогает абитуриентам и студентам с профориентацией. «Система аналитики больших данных подбирает для каждого обучающегося индивидуальную траекторию учебы с выбором наиболее подходящих предметов. Например, это актуально на программах повышения квалификации и переподготовки», — отмечает доктор экономических наук.

Промышленность

Компании используют большие данные для оптимизации производственных процессов, предотвращения сбоев в оборудовании, улучшения качества продукции и управления цепочками поставок. В качестве примера Александр Дмитриев приводит опыт газового концерна «Газпром». «Компания выявила неисправности в системе энергоснабжения и компрессорного оборудования. Это позволило выявить причинно-следственные связи появления сбоев в работе и оперативно их устранить», — рассказывает эксперт.

Технологии обработки Big Data

Как рассказывает основатель и продюсер компании «РОББО» Павел Фролов, для хранения и обработки данных главным образом используют три технологии:

классическая реляционная система управления базами данных (СУБД); горизонтально масштабируемое хранилище данных; система работы с данными in-memory.

Классическая реляционная СУБД — это система, данные в которой находятся и логически обрабатываются «на одном сервере» в одной базе с заданной структурой, а для работы с данными используется язык SQL. Такие системы получили наибольшее распространение, а практически весь глобальный рынок занят тремя производителями — Oracle, Microsoft и IBM.

В случае с горизонтально масштабируемым хранилищем данных речь идет о системе, где данные распределяются по большому количеству серверов. Они могут не иметь заранее определенной структуры, при этом в хранилище можно добавлять новые серверы. Анализ данных происходит на всех серверах параллельно, результат параллельных вычислений консолидируется. Так работает Hadoop, и для подобных вычислений была придумана технология MapReduce.

Системы работы с данными in-memory позволяют создавать и анализировать структурированные и слабоструктурированные данные в режиме реального времени с высокой производительностью. Это системы, сочетающие в себе достоинства OLTP (транзакционных) и OLAP (аналитических) систем, являющиеся обработчиками так называемых горячих, то есть наиболее актуальных на настоящий момент данных. Примером такой системы может служить SAP HANA.

Если говорить об инструментах обработки больших данных, то можно выделить следующие:

Apache Hadoop. Это один из наиболее популярных фреймворков для обработки больших данных. Hadoop включает в себя распределенную файловую систему HDFS и фреймворк для обработки данных MapReduce.

Apache Spark. Это высокопроизводительный фреймворк для параллельной обработки данных, который предоставляет API на Java, Scala, Python и R. Spark поддерживает обработку данных в реальном времени и в памяти, что делает его более быстрым по сравнению с Hadoop MapReduce.

NoSQL-базы данных. NoSQL-базы данных, такие как Apache Cassandra, MongoDB и Couchbase, предоставляют масштабируемые и гибкие решения для хранения и обработки неструктурированных данных, что особенно важно для Big Data-приложений.

Фреймворки для обработки потоков данных. Технологии, такие как Apache Kafka, Apache Storm и Apache Flink, позволяют обрабатывать и анализировать данные в режиме реального времени, обеспечивая надежный и эффективный поток данных.

Машинное обучение и искусственный интеллект. Технологии машинного обучения и искусственного интеллекта используются для анализа больших данных, выявления паттернов, прогнозирования трендов и автоматизации процессов принятия решений.

Кластерные системы управления данными. Системы управления данными, такие как Apache HBase, предоставляют распределенные хранилища для работы с большими объемами данных, обеспечивая быстрый доступ к данным и поддерживая масштабируемость.

Технологии для визуализации данных. Инструменты для визуализации данных, такие как Tableau, Power BI и D3.js, позволяют создавать наглядные диаграммы и графику на основе больших данных, что помогает понимать и анализировать информацию.

Проблемы и вызовы Big Data

Одним из основных барьеров для внедрения аналитики больших данных в бизнес является необходимость достаточно крупных капитальных инвестиций. Они необходимы для запуска систем аналитики больших данных, говорит Александр Дмитриев.

Учитывая востребованность специалистов по машинному обучению (ML, machine learning) и Big Data, один только годовой зарплатный фонд команды из трех человек может обойтись в 12-15 миллионов рублей Филипп Вольнов директор по маркетингу платформы автоматизации маркетинга

«Поэтому для маркетингового направления вкладываться в собственную ML/Big Data инфраструктуру стоит только, если есть сильные гипотезы, которые обеспечат прирост выручки», — называет порядок цифр Филипп Вольнов.

Помимо финансовых, можно выделить еще некоторое количество проблем и вызовов:

Объем данных. Обработка и хранение огромных объемов данных требует значительных вычислительных ресурсов и инфраструктуры, что может быть дорого и сложно в управлении.

Скорость обработки. Обработка больших данных в реальном времени требует быстрых алгоритмов и инфраструктуры, способных справляться с высокой скоростью поступления данных.

Качество данных. Большие данные могут быть зашумленными и содержать ошибки. Обеспечение качества данных и их очистка от ошибок и шума представляют сложность.

Обработка больших данных часто включает конфиденциальные или чувствительные данные, что поднимает вопросы о безопасности и защите информации

Интеграция данных. Большие данные могут быть распределены в различных источниках и форматах. Их интеграция в унифицированный формат для анализа и обработки может быть сложной задачей.

Этика и законодательство. Обработка больших данных поднимает вопросы об этике, такие как конфиденциальность данных и справедливость в использовании информации. Существуют законодательные ограничения, регулирующие сбор, хранение и использование данных. Например, в России отсутствует законодательно закрепленное определение больших данных, говорит Павел Фролов.

Какое будущее у Big Data?

Будущее Big Data обещает множество возможностей и инноваций, поскольку технологии обработки данных продолжают развиваться. В настоящее время это одно из наиболее перспективных направлений в IT, в том числе в отношении зарплат и продвижения по карьерной лестнице. Вот несколько направлений, в которых можно ожидать развития:

Улучшение технологий обработки данных

С появлением более мощных вычислительных систем и оптимизированных алгоритмов обработки данных возможности анализа и интерпретации больших объемов данных значительно увеличатся.

Расширение области применения

Big Data будет продолжать проникать в различные сферы, такие как здравоохранение, финансы, производство, транспорт и другие, что позволит оптимизировать процессы и принимать более осознанные бизнес-решения.

Обработка данных в реальном времени

С развитием технологий обработки потоков данных (stream processing) анализ данных в реальном времени станет более распространенным. Это позволит быстрее реагировать на изменения и события.

Увеличение роли искусственного интеллекта в обработке данных

Искусственный интеллект будет активно применяться для автоматизации процессов анализа больших данных, включая распознавание образов, обработку текста, голосовой анализ и многое другое.

Развитие технологий безопасности

С увеличением объемов данных растут и угрозы безопасности. Поэтому будут разрабатываться более сложные и эффективные технологии обеспечения безопасности данных.

Увеличение роли облачных технологий

Облачные решения позволяют хранить и обрабатывать большие объемы данных без необходимости владения собственной инфраструктурой. Соответственно, удешевление поможет сделать Big Data более доступной для малых и средних предприятий.

Сама по себе Big Data — не панацея, добавляет Филипп Вольнов. «Фактор, который часто недооценивают — чистота данных. Если в различных источниках хранится информация, которая противоречива или не может быть "склеена", то "картинка" в отчетах будет отличаться от действительности. Поэтому компаниям приходится вкладывать деньги в такие инструменты как CDP, которые отвечают за автоматическую дедупликацию ("склеивание") и очистку данных», — говорит эксперт.

Другая сложность — правильная интерпретация Big Data, продолжает маркетолог. Например, продуктовые рекомендации одного большого ретейлера утверждали, что самый популярный продукт среди клиентов — целлофановый пакет за три рубля, поэтому его надо советовать в качестве сопутствующего товара абсолютно всем. В данном случае, говорит Филипп Вольнов, получаемые данные не были должным уровнем обработаны, что привело к неправильным выводам.